이 가이드에서는 한 가지 유형의 evaluator(LLM-as-a-judge)를 설정하고 실행하는 방법을 보여줍니다. 사용 예제가 포함된 사전 구축된 evaluator의 전체 목록은 openevals 및 agentevals 저장소를 참조하세요.

Setup

사전 구축된 LLM-as-a-judge evaluator를 사용하려면openevals 패키지를 설치해야 합니다.

openevals는 evaluate 메서드와도 원활하게 통합됩니다. 설정 지침은 해당 가이드를 참조하세요.

Evaluator 실행하기

일반적인 흐름은 간단합니다:openevals에서 evaluator 또는 factory function을 import한 다음, 테스트 파일 내에서 inputs, outputs, reference outputs와 함께 실행합니다. LangSmith는 evaluator의 결과를 자동으로 feedback으로 기록합니다.

모든 evaluator가 각 매개변수를 필요로 하는 것은 아닙니다(예를 들어, exact match evaluator는 outputs와 reference outputs만 필요합니다). 또한 LLM-as-a-judge prompt에 추가 변수가 필요한 경우, kwargs로 전달하면 prompt에 포맷됩니다.

다음과 같이 테스트 파일을 설정하세요:

feedback_key/feedbackKey 매개변수는 실험에서 feedback의 이름으로 사용됩니다.

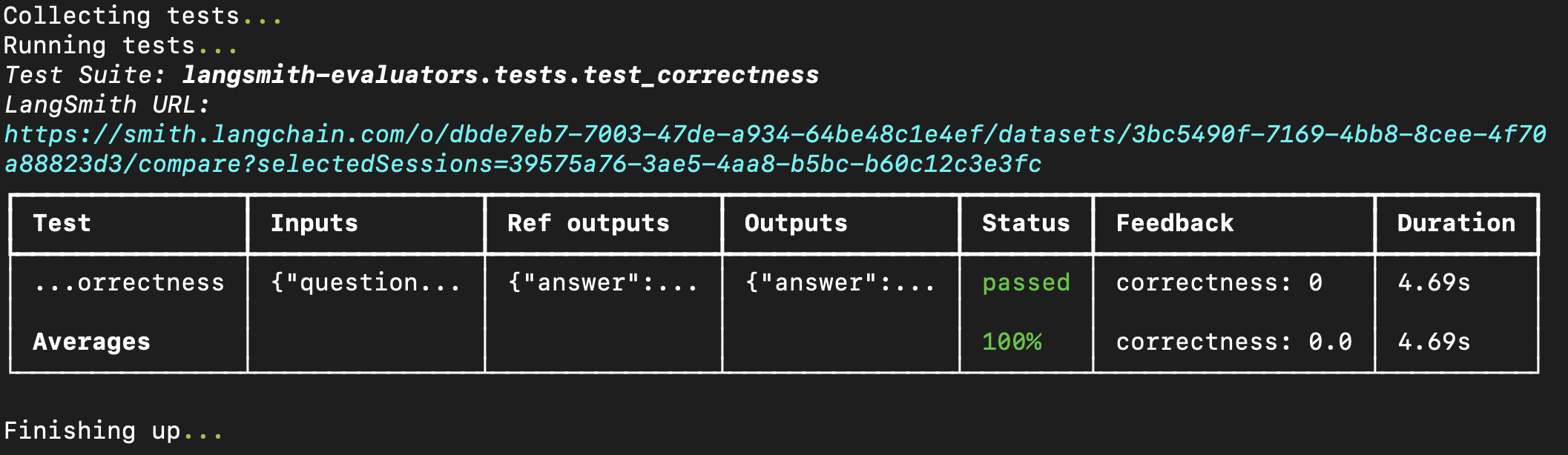

터미널에서 평가를 실행하면 다음과 같은 결과가 나타납니다:

LangSmith에서 이미 dataset을 생성한 경우 사전 구축된 evaluator를

LangSmith에서 이미 dataset을 생성한 경우 사전 구축된 evaluator를 evaluate 메서드에 직접 전달할 수도 있습니다. Python을 사용하는 경우 langsmith>=0.3.11이 필요합니다:

Connect these docs programmatically to Claude, VSCode, and more via MCP for real-time answers.