- 데이터셋: 테스트 입력(및 선택적으로 기대 출력) 집합입니다.

- 타겟 함수: 테스트하려는 애플리케이션의 부분—새 프롬프트가 적용된 단일 LLM 호출, 하나의 모듈, 또는 전체 워크플로우일 수 있습니다.

- 평가자: 타겟 함수의 출력을 점수화하는 함수입니다.

트레이싱 시작에 대한 동영상 시청을 원하신다면, 데이터셋 및 평가 동영상 가이드를 참고하세요.

사전 준비 사항

시작하기 전에 다음을 준비하세요:- LangSmith 계정: smith.langchain.com에서 가입하거나 로그인하세요.

- LangSmith API 키: API 키 생성 가이드를 따라주세요.

- OpenAI API 키: OpenAI 대시보드에서 생성하세요.

- UI

- SDK

1. 워크스페이스 시크릿 설정

LangSmith UI에서 OpenAI API key가 workspace secret으로 설정되어 있는지 확인하세요.- Settings로 이동한 다음 Secrets 탭으로 이동합니다.

- Add secret을 선택하고

OPENAI_API_KEY를 입력한 후 API key를 Value로 입력합니다. - Save secret을 선택합니다.

LangSmith UI에서 workspace secret을 추가할 때, secret key가 모델 제공자가 예상하는 environment variable 이름과 일치하는지 확인하세요.

2. 프롬프트 생성

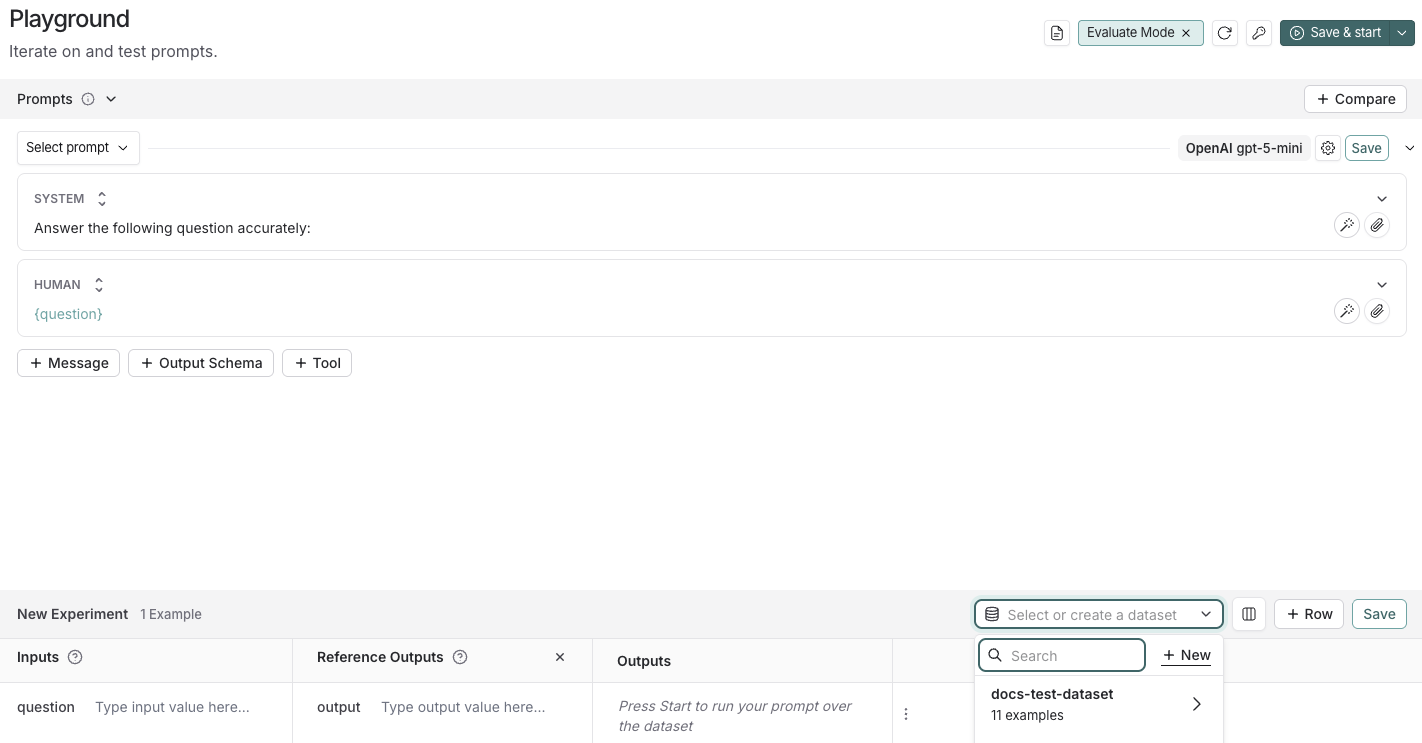

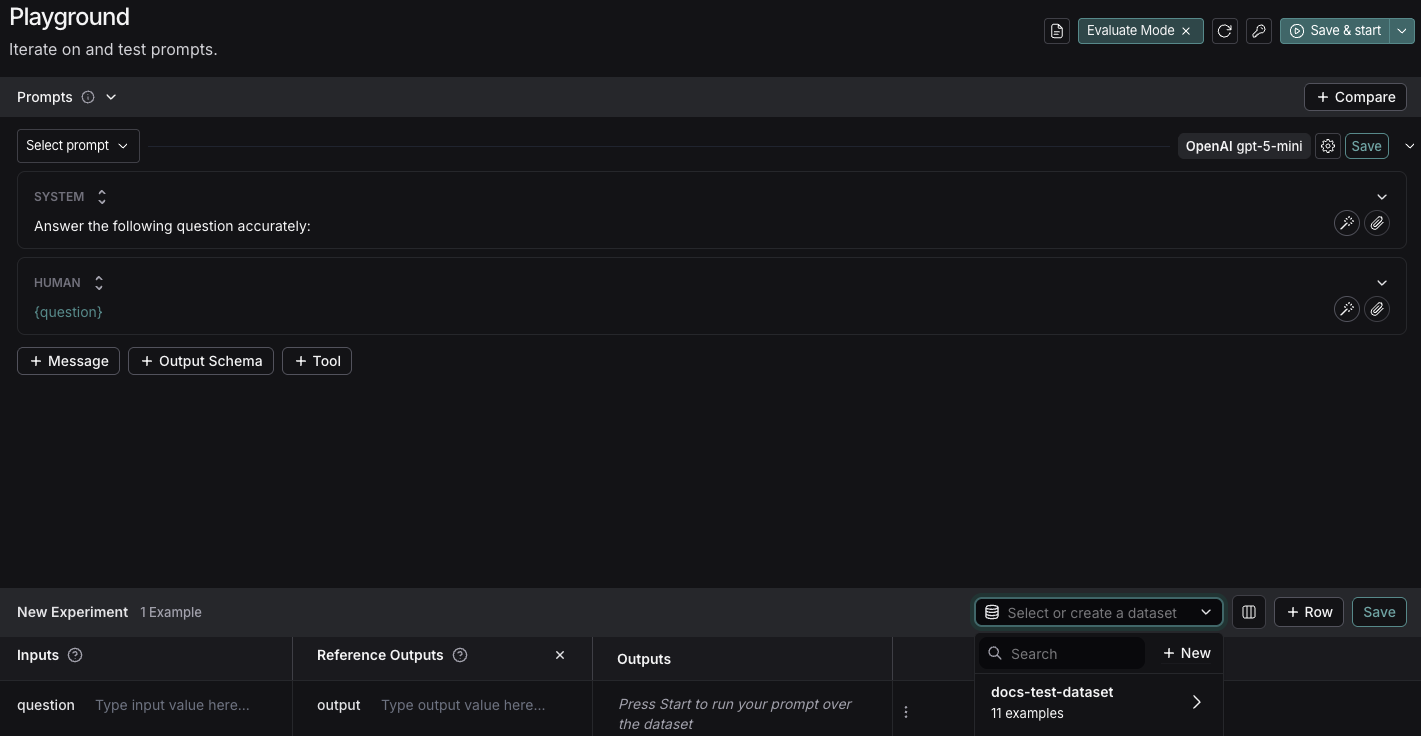

LangSmith의 Prompt Playground를 사용하면 다양한 프롬프트, 새로운 모델, 또는 다양한 모델 설정에 대해 평가를 실행할 수 있습니다.- LangSmith UI에서 Prompt Engineering 아래의 Playground로 이동하세요.

-

Prompts 패널에서 system 프롬프트를 다음과 같이 수정하세요:

Human 메시지는 그대로 두세요:

{question}.

3. 데이터셋 생성

- Set up Evaluation을 클릭하면 페이지 하단에 New Experiment 테이블이 열립니다.

-

Select or create a new dataset 드롭다운에서 + New 버튼을 클릭하여 새 데이터셋을 만드세요.

-

데이터셋에 다음 예시를 추가하세요:

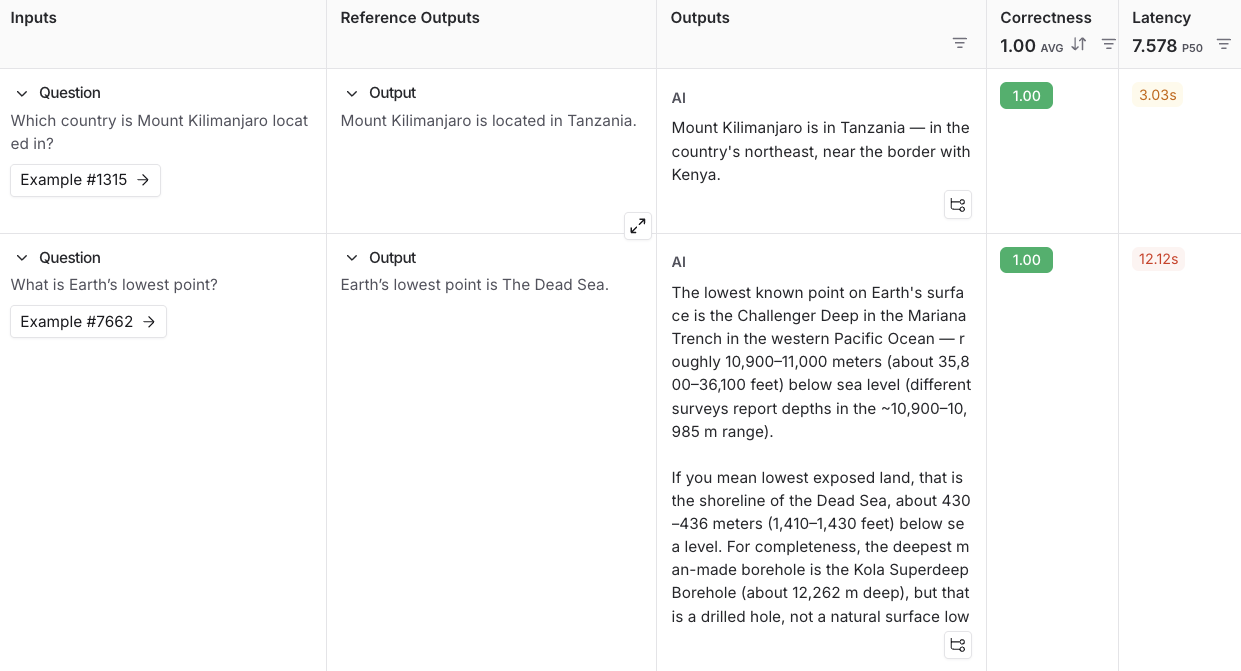

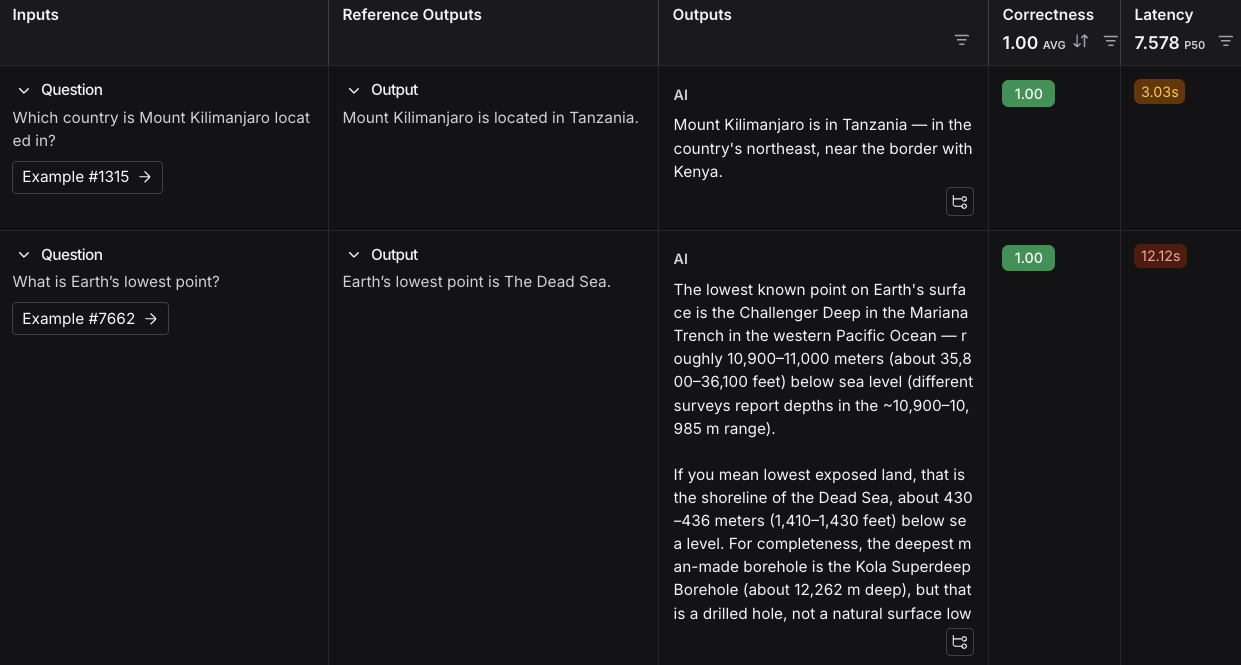

Inputs Reference Outputs question: Which country is Mount Kilimanjaro located in? output: Mount Kilimanjaro is located in Tanzania. question: What is Earth’s lowest point? output: Earth’s lowest point is The Dead Sea. - Save를 클릭하고 이름을 입력하여 새로 만든 데이터셋을 저장하세요.

4. 평가자 추가

- + Evaluator를 클릭하고 Pre-built Evaluator 옵션에서 Correctness를 선택하세요.

- Correctness 패널에서 Save를 클릭하세요.

5. 평가 실행

-

오른쪽 상단에서 Start를 선택하여 평가를 실행하세요. 그러면 New Experiment 테이블에 미리보기가 있는 실험이 생성됩니다. 실험 이름을 클릭하면 전체 결과를 볼 수 있습니다.

다음 단계

LangSmith에서 실험을 실행하는 방법에 대해 더 알고 싶다면 평가 개념 가이드를 읽어보세요.

- 평가에 대한 자세한 내용은 평가 문서를 참고하세요.

- UI에서 데이터셋 생성 및 관리 방법을 알아보세요.

- 프롬프트 플레이그라운드에서 평가 실행 방법을 알아보세요.

동영상 가이드

Connect these docs programmatically to Claude, VSCode, and more via MCP for real-time answers.