- 환경을 구성합니다.

- 컨텍스트를 검색하고 LLM을 호출하는 애플리케이션을 생성합니다.

- 검색 단계와 LLM 호출을 모두 캡처하도록 tracing을 활성화합니다.

- LangSmith UI에서 결과 trace를 확인합니다.

tracing 시작에 대한 비디오를 선호하는 경우 빠른 시작 비디오 가이드를 참조하세요.

사전 요구사항

시작하기 전에 다음이 있는지 확인하세요:- LangSmith 계정: smith.langchain.com에서 가입하거나 로그인하세요.

- LangSmith API key: API key 생성 가이드를 따르세요.

- OpenAI API key: OpenAI 대시보드에서 생성하세요.

LangChain 또는 LangGraph로 애플리케이션을 구축하는 경우 단일 환경 변수로 LangSmith tracing을 활성화할 수 있습니다. LangChain으로 tracing 또는 LangGraph로 tracing 가이드를 읽고 시작하세요.

1. 디렉토리 생성 및 종속성 설치

터미널에서 프로젝트용 디렉토리를 생성하고 환경에 종속성을 설치합니다:2. 환경 변수 설정

다음 환경 변수를 설정합니다:LANGSMITH_TRACINGLANGSMITH_API_KEYOPENAI_API_KEY(또는 LLM provider의 API key)- (선택사항)

LANGSMITH_WORKSPACE_ID: LangSmith API가 여러 workspace에 연결된 경우 사용할 workspace를 지정하려면 이 변수를 설정하세요.

3. 애플리케이션 정의

이 단계에 설명된 예제 앱 코드를 사용하여 RAG 애플리케이션을 계측할 수 있습니다. 또는 LLM 호출을 포함하는 자체 애플리케이션 코드를 사용할 수 있습니다. 이것은 아직 LangSmith tracing이 추가되지 않은 OpenAI SDK를 직접 사용하는 최소한의 RAG 앱입니다. 세 가지 주요 부분이 있습니다:- Retriever function: 항상 동일한 문자열을 반환하는 문서 검색을 시뮬레이션합니다.

- OpenAI client: chat completion 요청을 보내기 위해 일반 OpenAI client를 인스턴스화합니다.

- RAG function: 검색된 문서를 사용자의 질문과 결합하여 system prompt를 형성하고,

gpt-4o-mini로chat.completions.create()endpoint를 호출하고, assistant의 응답을 반환합니다.

app.py 또는 app.ts)에 다음 코드를 추가합니다:

4. LLM 호출 추적

시작하려면 모든 OpenAI 호출을 추적합니다. LangSmith는 wrapper를 제공합니다:- Python:

wrap_openai - TypeScript:

wrapOpenAI

-

앱 파일에 강조 표시된 줄을 포함합니다:

-

애플리케이션을 호출합니다:

다음 출력을 받게 됩니다:

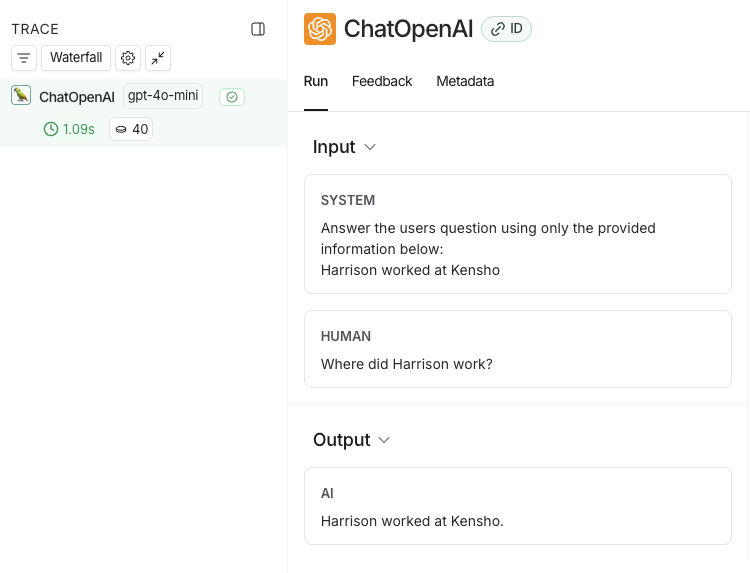

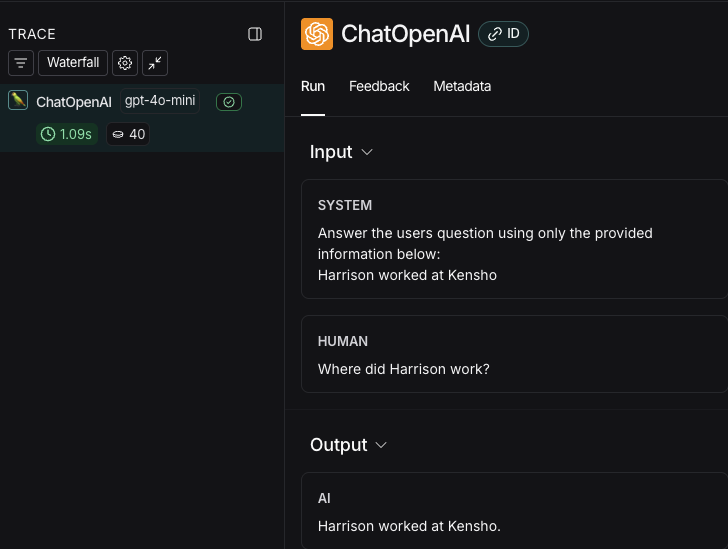

- LangSmith UI에서 workspace의 default Tracing Project(2단계에서 지정한 workspace)로 이동합니다. 방금 계측한 OpenAI 호출을 볼 수 있습니다.

5. 전체 애플리케이션 추적

LLM 호출만이 아닌 전체 애플리케이션을 추적하기 위해 Python 또는 TypeScript용traceable decorator를 사용할 수도 있습니다.

-

앱 파일에 강조 표시된 코드를 포함합니다:

-

run을 생성하기 위해 애플리케이션을 다시 호출합니다:

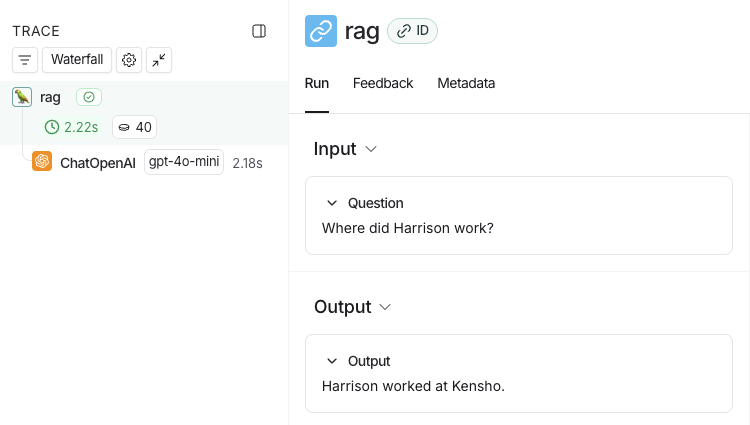

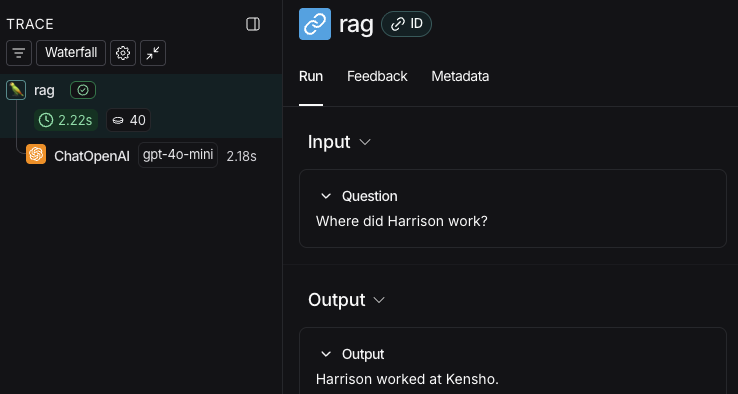

- LangSmith UI로 돌아가서 workspace의 default Tracing Project(2단계에서 지정한 workspace)로 이동합니다. rag 단계와 ChatOpenAI LLM 호출이 포함된 전체 앱 파이프라인의 trace를 찾을 수 있습니다.

다음 단계

다음으로 탐색할 수 있는 몇 가지 주제는 다음과 같습니다:- Tracing 통합은 다양한 LLM provider 및 agent framework에 대한 지원을 제공합니다.

- Trace 필터링은 상당한 양의 데이터가 포함된 tracing project에서 데이터를 효과적으로 탐색하고 분석하는 데 도움이 될 수 있습니다.

- RAG 애플리케이션 추적은 개발부터 프로덕션까지 애플리케이션에 관찰 가능성을 추가하는 전체 튜토리얼입니다.

- 특정 project로 trace 전송은 trace의 대상 project를 변경합니다.

비디오 가이드

Connect these docs programmatically to Claude, VSCode, and more via MCP for real-time answers.