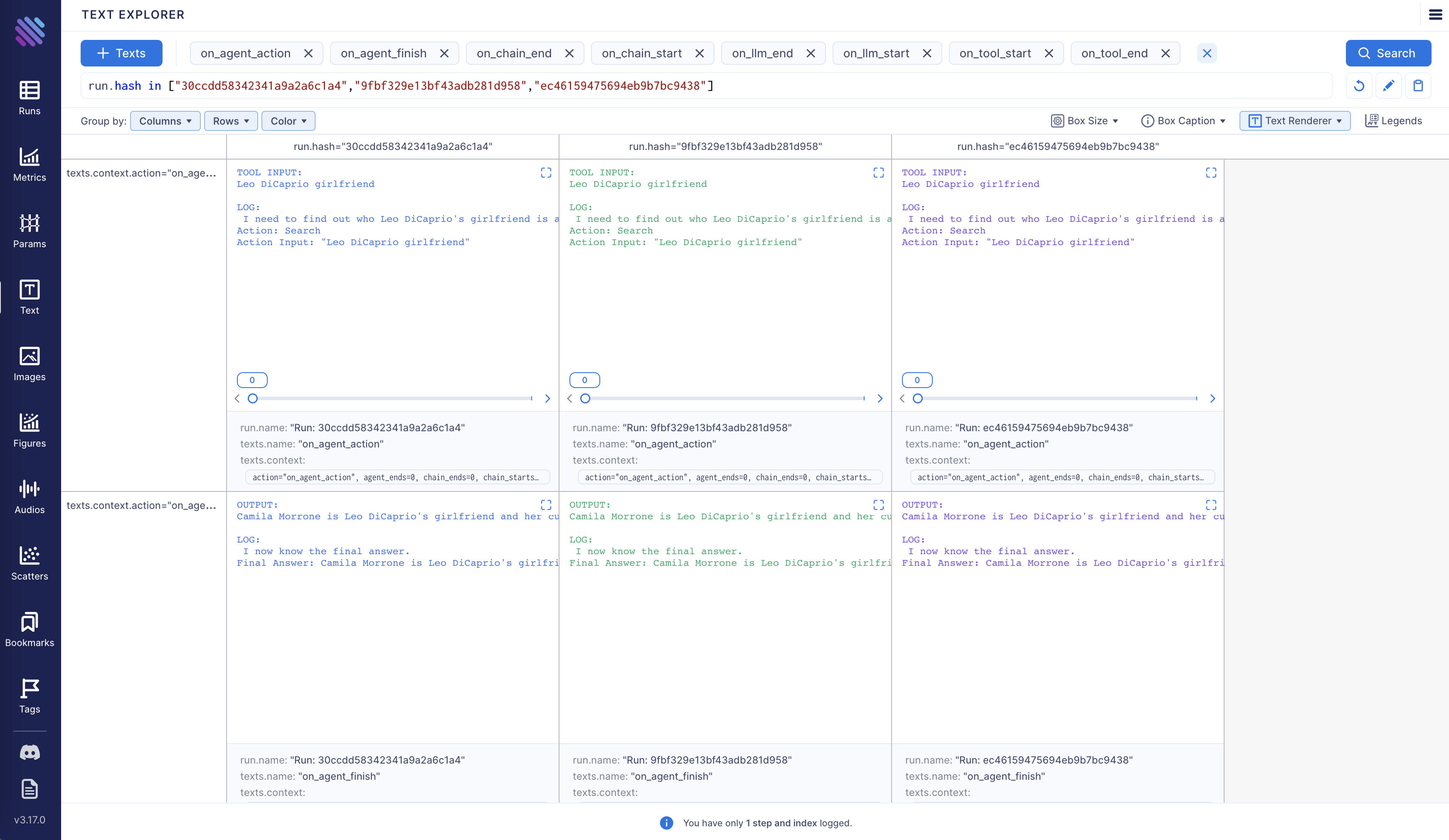

또한 여러 실행을 나란히 비교할 수 있는 옵션도 있습니다:

또한 여러 실행을 나란히 비교할 수 있는 옵션도 있습니다:

Aim은 완전한 오픈 소스입니다. GitHub에서 Aim에 대해 자세히 알아보세요.

이제 Aim callback을 활성화하고 구성하는 방법을 살펴보겠습니다.

Aim은 완전한 오픈 소스입니다. GitHub에서 Aim에 대해 자세히 알아보세요.

이제 Aim callback을 활성화하고 구성하는 방법을 살펴보겠습니다.

Aim으로 LangChain 실행 추적하기

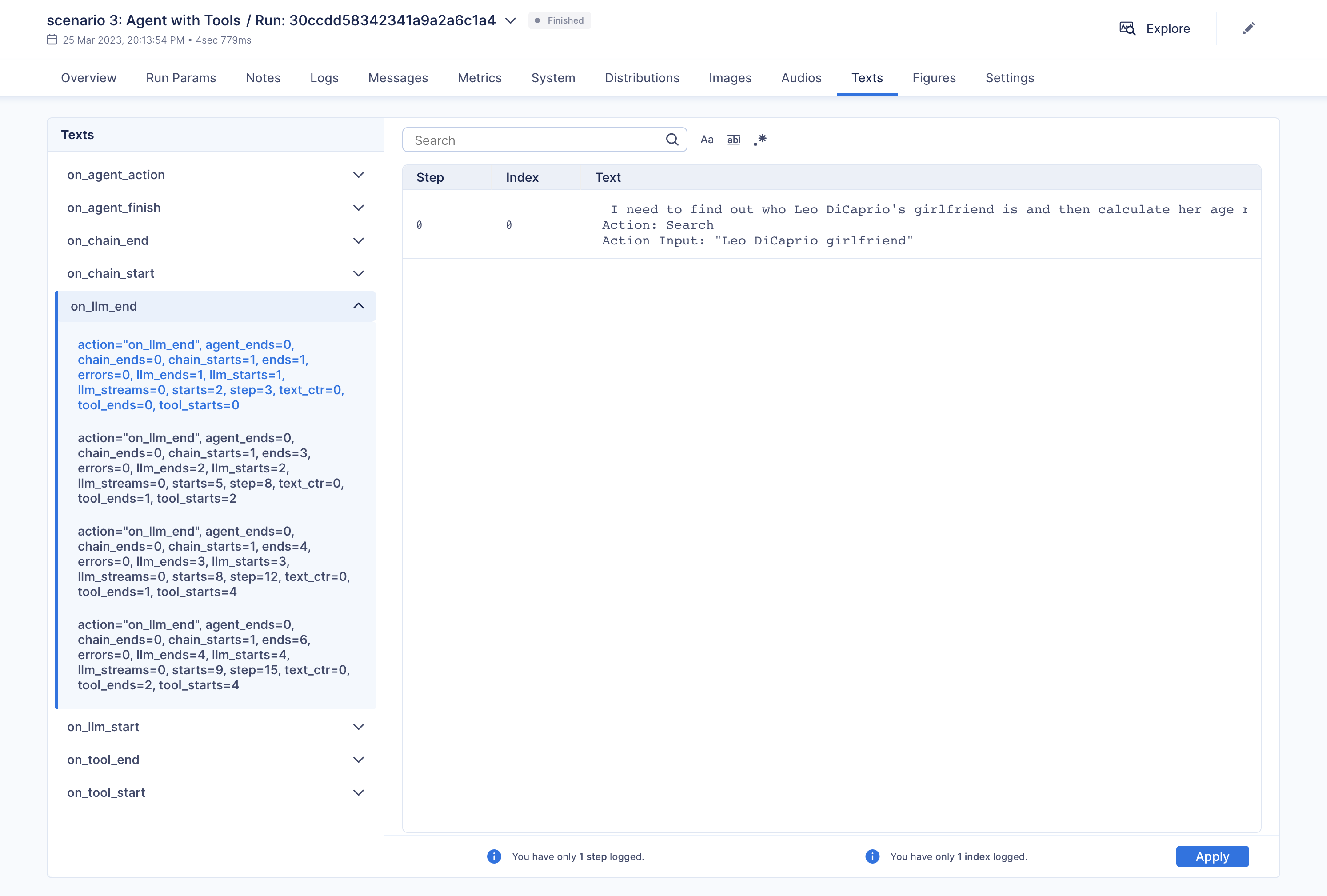

이 노트북에서는 세 가지 사용 시나리오를 살펴보겠습니다. 시작하기 위해 필요한 패키지를 설치하고 특정 모듈을 import하겠습니다. 그런 다음 Python 스크립트 내에서 또는 터미널을 통해 설정할 수 있는 두 개의 환경 변수를 구성하겠습니다.AimCallbackHandler의 event method는 LangChain module 또는 agent를 입력으로 받아 최소한 prompt와 생성된 결과, 그리고 LangChain module의 직렬화된 버전을 지정된 Aim run에 기록합니다.

flush_tracker function은 Aim에 LangChain asset을 기록하는 데 사용됩니다. 기본적으로 session은 완전히 종료되지 않고 재설정됩니다.

시나리오 1

첫 번째 시나리오에서는 OpenAI LLM을 사용합니다.시나리오 2

두 번째 시나리오는 여러 generation에 걸쳐 여러 SubChain을 연결하는 것입니다.시나리오 3

세 번째 시나리오는 tool을 사용하는 agent입니다.Connect these docs programmatically to Claude, VSCode, and more via MCP for real-time answers.